22 KiB

22 KiB

Zusammenfassung für CDS-1011 Einführung in Data Science

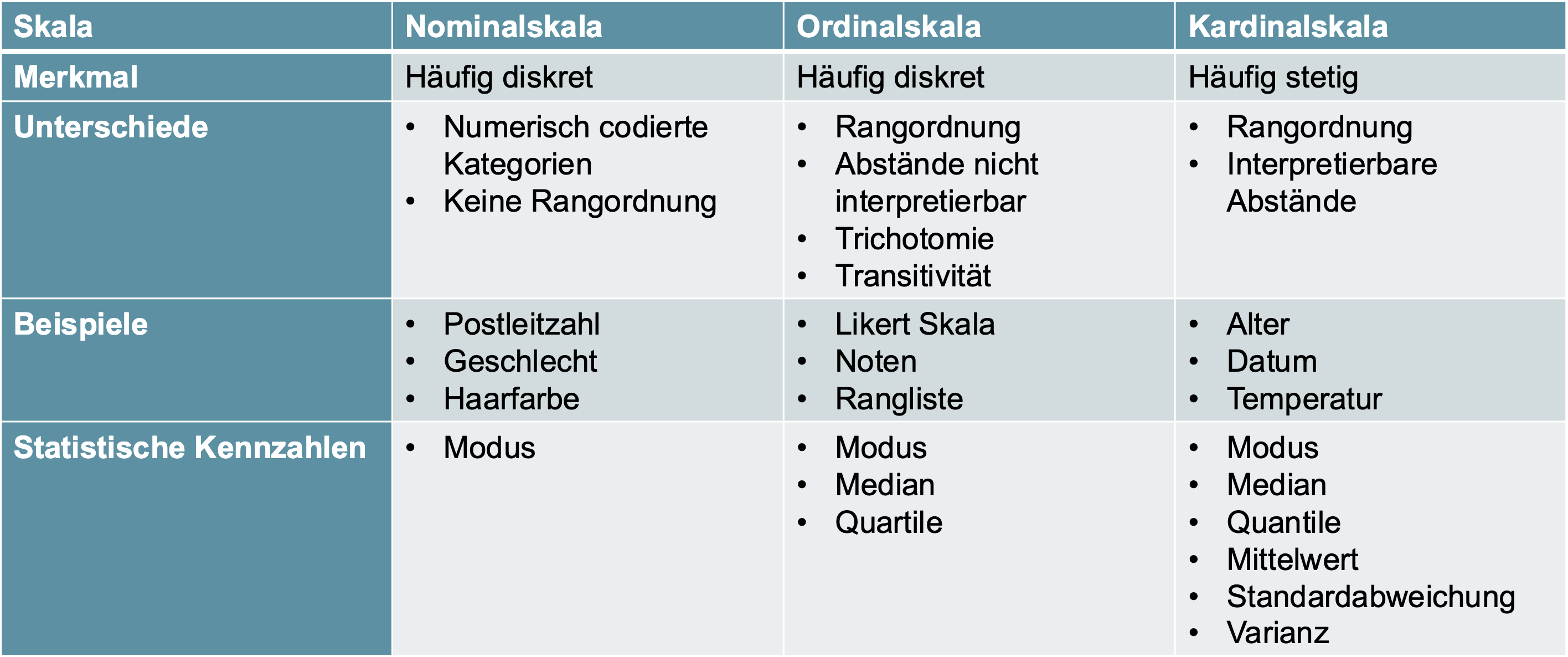

Grundbegriffe

| Begriff | Beschreibung |

|---|---|

| Daten | Beispiele: Transaktionsdaten, Log-Daten, Maschinendaten, Dokumente / Texte, Social Media, Videos, Bilder |

| Data Science | Fachgebiet, welches sich mit der Gewinnung von Wissen aus Daten beschäftigt |

| Artificial Intelligence | Systeme, die intelligentes Verhalten aufweisen. Indem sie ihre Umgebung analysieren und Massnahmen ergreiffen, mit einen gewissen Grad an Selbstbestimmung. Um dann bestimmte Ziele zu erreichen |

| Machine Learning | Machine Learning beschäftigt sich mit der Frage, wie man Computer Programme so entwerfen kann, dass sie sich, mit Erfahrung, automatisch verbessern |

| Deep Learning | Deep Learning ist eine unterkategorie von AI, die ihren Fokus auf die Erstellung von künstlichen neuronalen Netzen (KNN) setzt. KNN sind in der Lage, genaue datengestützte Entscheidungen zu treffen |

| Features | Features sind die verschiedenen Attribute, die einen informationsreichen Datensatz bilden, der zum Trainieren von Modellen für maschinelles Lernen verwendet wird. Diese Merkmale werden als Eingabe für das Modell verwendet, um genaue Vorhersagen für die Labels zu treffen. |

| Labels (Zielvariablen) | Ein Label, auch als Zielvariable oder abhängige Variable bezeichnet, ist die Ausgabe, für deren Vorhersage das Modell trainiert wird. Beim überwachten Lernen sind Labels die bekannten Ergebnisse, die das Modell während des Trainings mit den Eingabemerkmalen zu verknüpfen lernt. |

| Parameter | Ein Parameter ist eine Variable, die während des Trainingsprozesses aus den Daten gelernt wird. Er wird verwendet, um die zugrunde liegenden Beziehungen in den Daten darzustellen und um Vorhersagen über neue Daten zu treffen. |

| Hyperparameter | A hyperparameter, on the other hand, is a variable that is set before the training process begins. It controls the behaviour of the learning algorithm, such as the learning rate, the regularization strength, and the number of hidden layers in a neural network. Z.B. Anzahl Clusters bei einer Clustering Aufgabe |

Machine Larning

| Begriff | Beschreibung |

|---|---|

| Überwachtes Lernen |

|

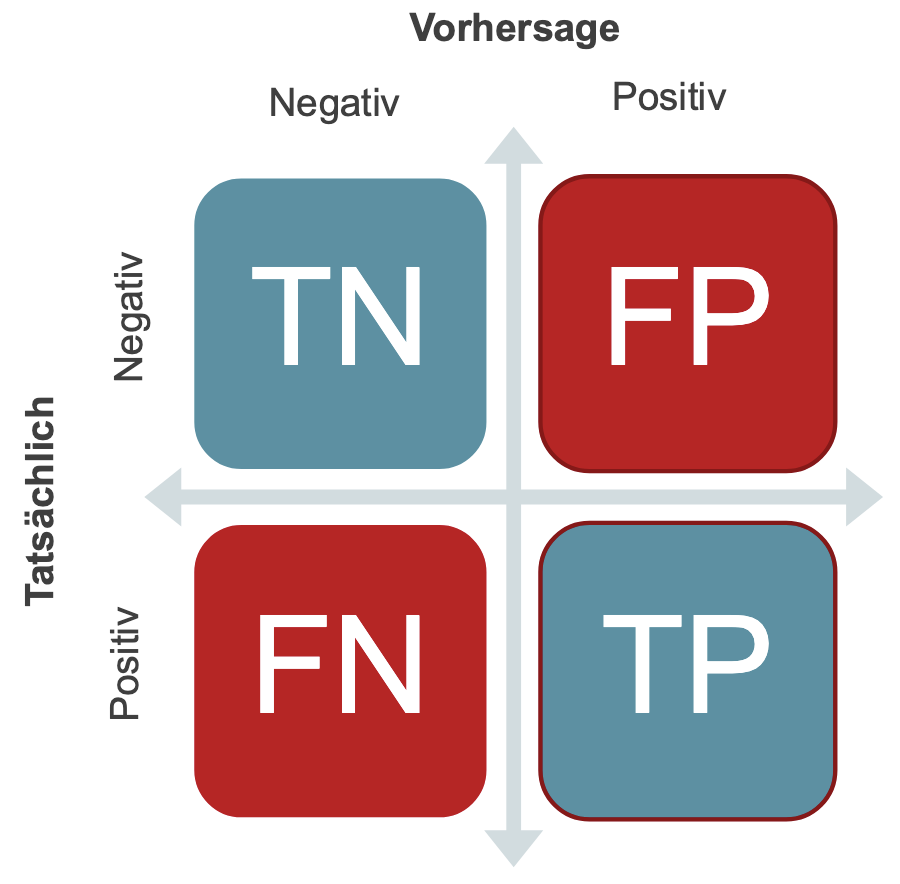

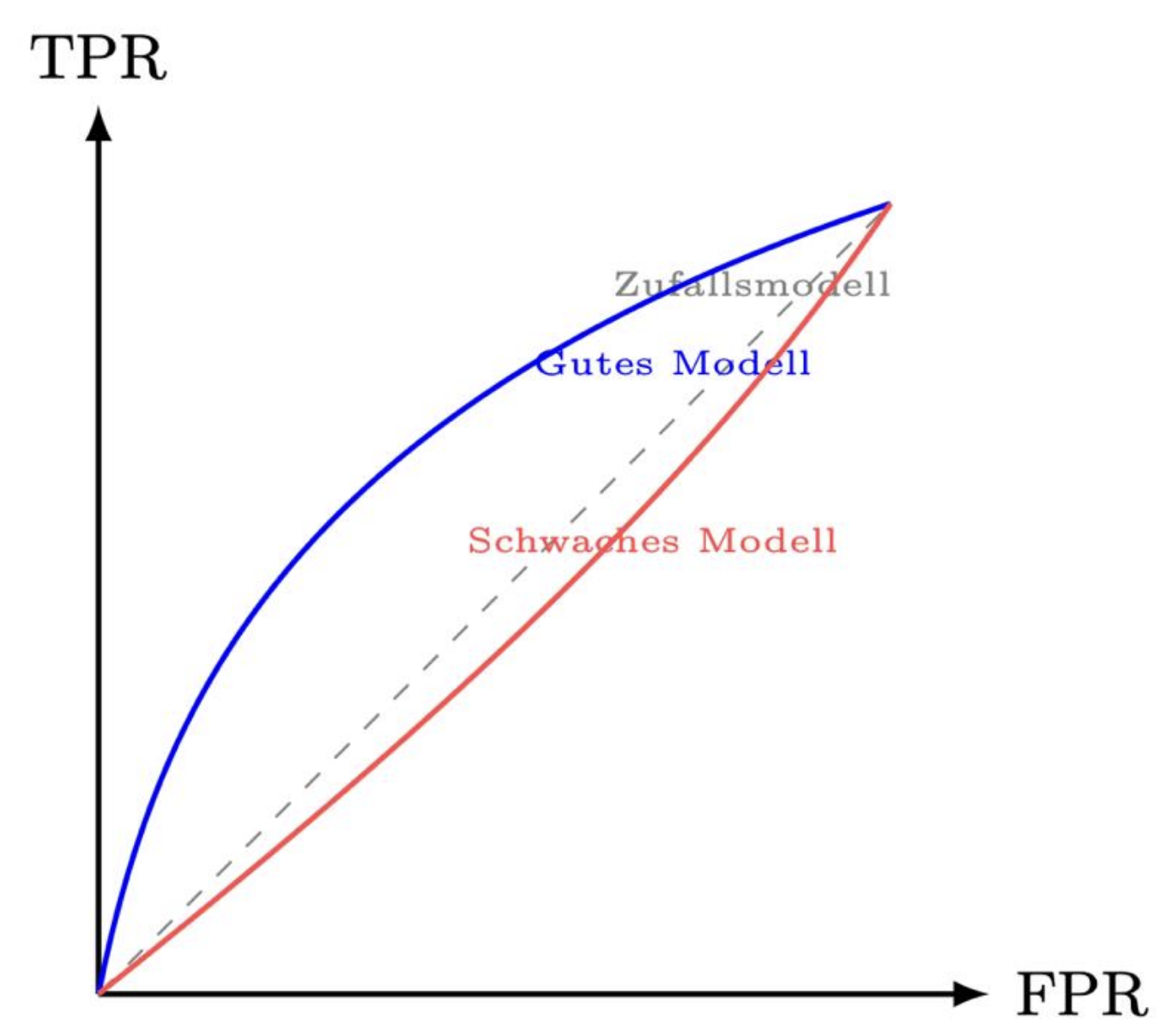

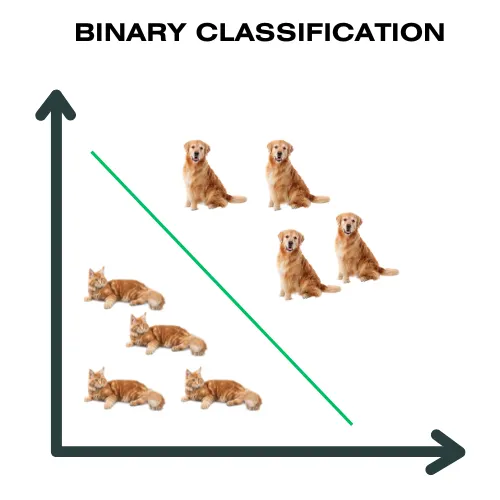

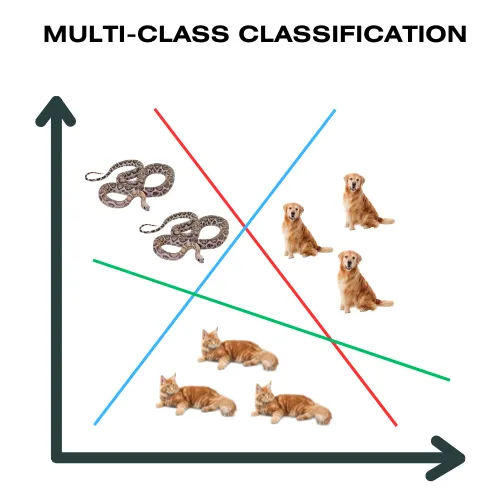

| Klassifizierung | Methode des überwachten Lernens, bei der ein Modell anhand von gelabelten Beispieldaten lernt, neue Datenpunkte vordefinierten Kategorien (Klassen) zuzuordnen, z.B. Bilder als "Hund" oder "Katze" zu erkennen, Spam-Mails zu filtern oder Kunden abzuwandern |

| Klassifizierung Algorithmen |

|

| Lineare Regression |

|

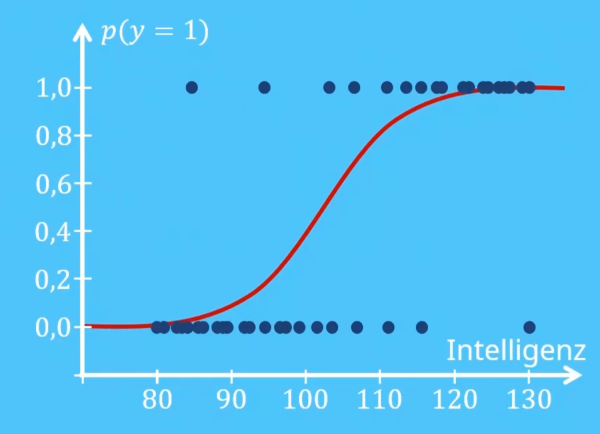

| Logistische Regression |

|

| Modell | Ein Machine-Learning-Modell ist ein Programm, das Muster findet oder auf Basis eines zuvor ungesehenen Datasets Entscheidungen trifft. |

| Unüberwachtes Lernen | Unüberwachtes Lernen (Unsupervised Learning) ist ein Bereich des maschinellen Lernens, bei dem Algorithmen Muster und Strukturen in ungelabelten Daten selbstständig entdecken, ohne vorherige menschliche Anleitungen oder vordefinierte Zielwerte. |

| Halbüberwachtes Lernen | Beim Semi-Supervised Learning wird ein Modell sowohl mit beschrifteten als auch mit unbeschrifteten Daten trainiert. Dabei lernt der Algorithmus mithilfe weniger gelabelter Datenpunkte, Muster in den Dateninstanzen ohne bekannte Zielvariable zu erkennen, was zu einer präziseren und effizienteren Modellbildung führt. |

| Reinforcement Learning | Reinforcement Learning ist ein Teilgebiet des maschinellen Lernens, das sich darauf konzentriert, wie Agenten durch Trial and Error lernen können, Entscheidungen zu treffen, um die kumulativen Belohnungen zu maximieren. RL ermöglicht es Maschinen, durch Interaktion mit einer Umgebung und durch Feedback zu ihren Handlungen zu lernen. Dieses Feedback erfolgt in Form von Belohnungen oder Strafen. |

| Batch Learning | Beim Batch-Lernen, auch Offline-Lernen genannt, wird ein maschinelles Lernmodell auf den gesamten Datensatz gleichzeitig trainiert, was zu einem statischen Modell führt, das nicht aus neuen Daten in der Produktion lernt und regelmässig mit aktualisierten Daten neu trainiert werden muss, um effektiv zu bleiben. |

| Online Learning | In der Informatik ist Online-Maschinelles Lernen eine Methode des maschinellen Lernens, bei der Daten in sequenzieller Reihenfolge verfügbar werden und dazu verwendet werden, bei jedem Schritt den besten Prädiktor für zukünftige Daten zu aktualisieren. Dies steht im Gegensatz zu Batch-Lernverfahren, bei denen der beste Prädiktor durch das gleichzeitige Lernen anhand des gesamten Trainingsdatensatzes generiert wird. |

| Instanzbasiertes Lernen | Eine einfache Methode besteht darin, dass das System direkt die Merkmale von neuen Datenpunkten mit denen der gelernten Datenpunkte vergleicht und ihre Ähnlichkeit vergleicht. Das bezeichnet man als instanzbasiertes Lernen. In der Trainingsphase lernt das System nur die Trainingsdaten. |

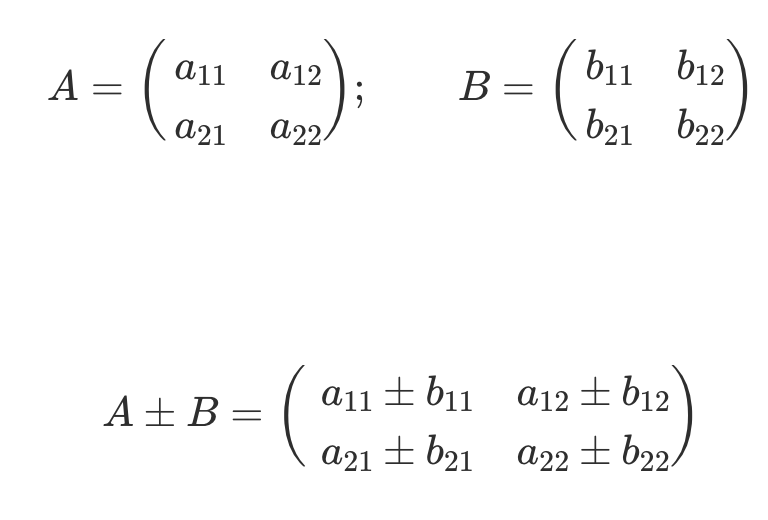

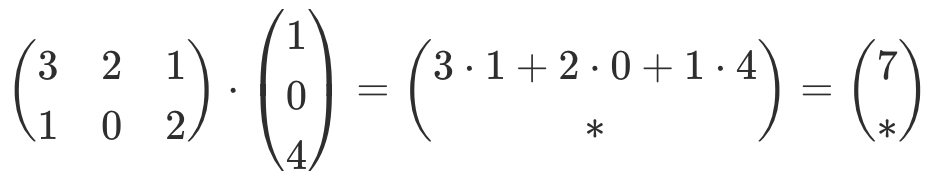

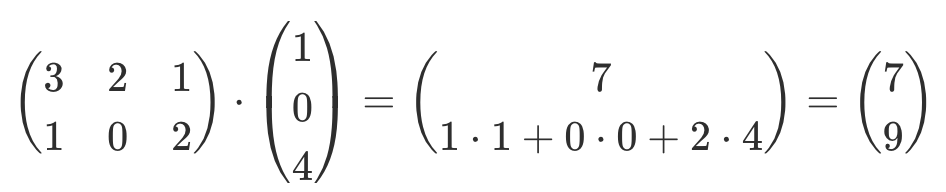

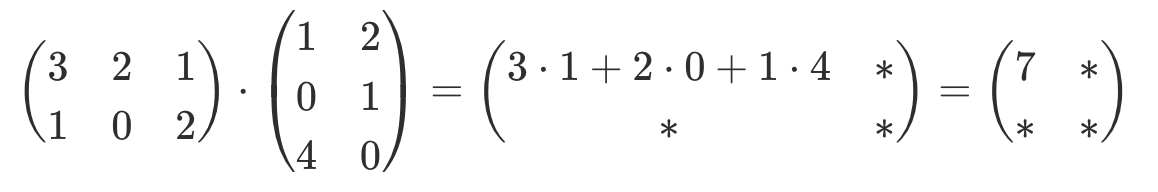

| Matrizen Operationen | Beispiel |

|---|---|

| Addition |  |

| Multiplikation mit Vektor |   |

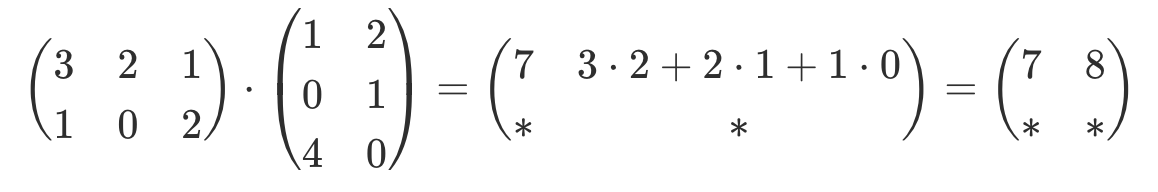

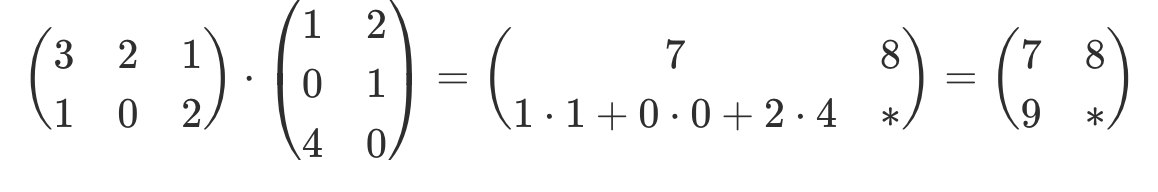

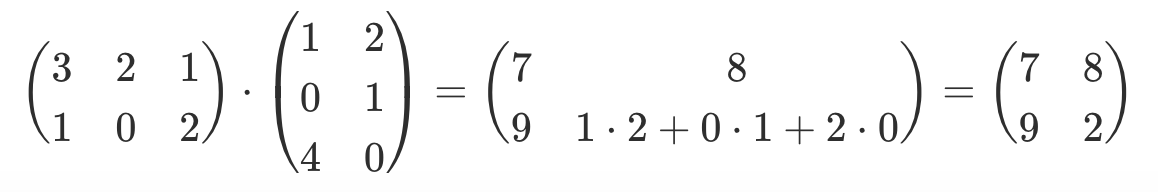

| Multiplikation |     |

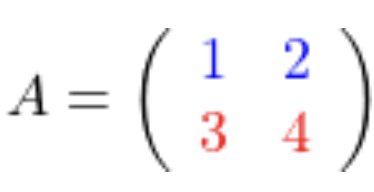

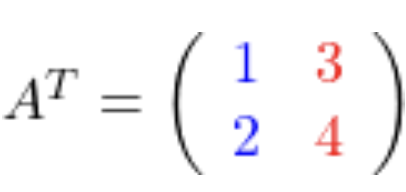

| Transponierte Matrizen |   |

Herausforderungen

Explorative Datenanalyse

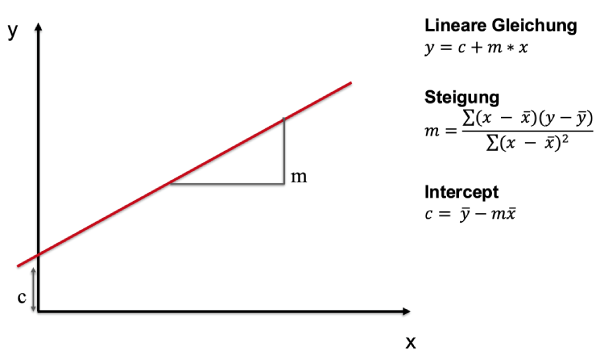

Lineare Regression

Regressionsgerade berechnen

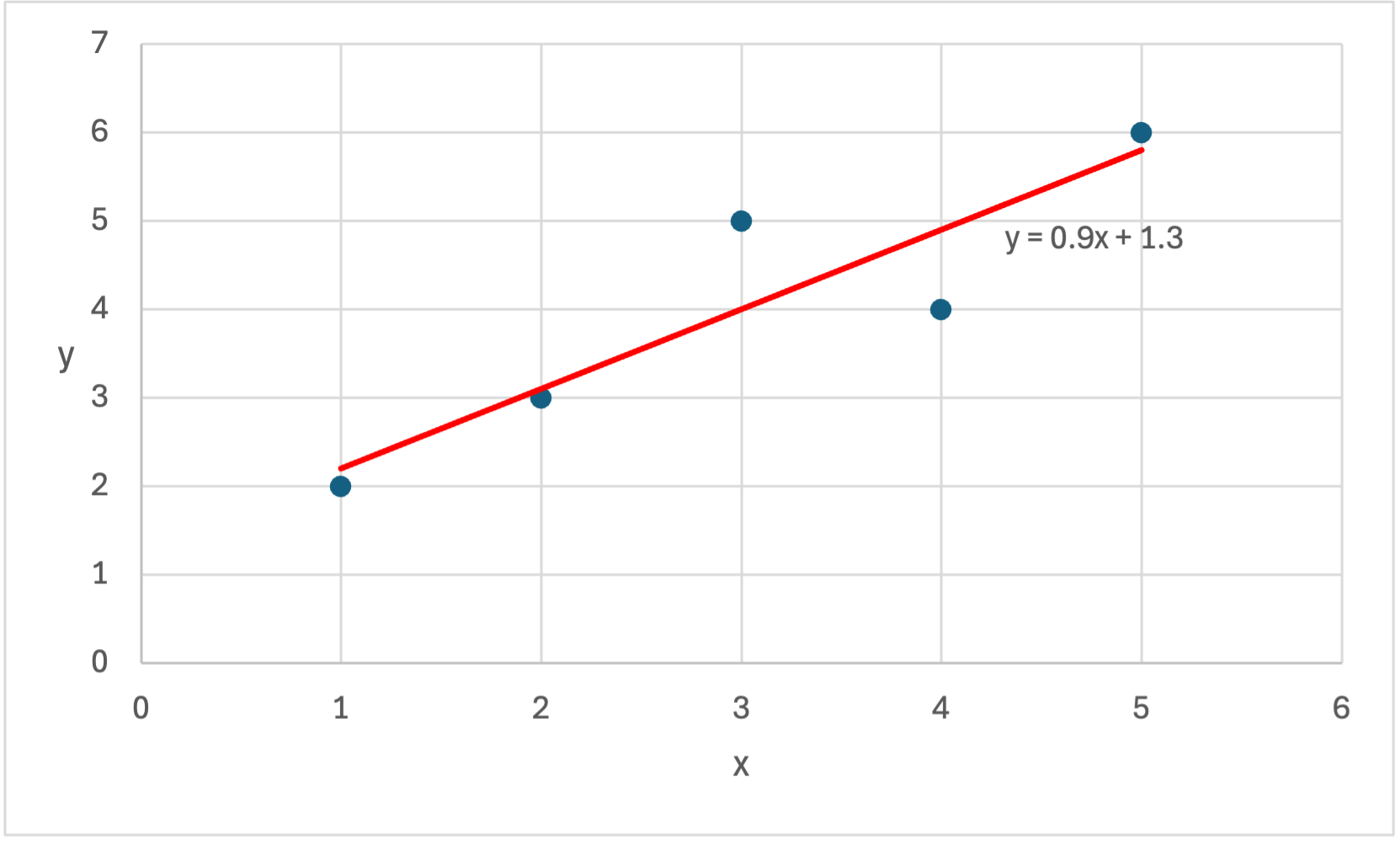

Beispiel:

x = [1, 2, 3, 4, 5], y = [2, 3, 5, 4, 6] \\

- x, y Tabelle erstellen

| x | y | x*y | x2 | |

|---|---|---|---|---|

| 1 | 2 | 2 | 1 | |

| 2 | 3 | 6 | 4 | |

| 3 | 5 | 15 | 9 | |

| 4 | 4 | 16 | 16 | |

| 5 | 6 | 30 | 25 | |

\sum |

15 | 20 | 69 | 55 |

- c Wert berechnen

c = \frac{\sum_y * \sum_x - \sum_x * \sum_{xy}}{n(\sum_{x^2}) - (\sum_x)^2} \\[1em]

c = \frac{20 * 55 - 15 * 69}{5*55 - 15^2} = 1.3

- m Wert berechnen

m = \frac{n(\sum_{xy}) - \sum_x * \sum_y}{n(\sum_{x^2} - (\sum_x)^2)} \\[1em]

m = \frac{5 * 69 - 15 * 20}{5 * 55 - 15^2} = 0.9

- Werte in Formel einsetzen

\hat{y} = mx+c \\

\hat{y} = 0.9x+1.3

- Funktionsgraphen mit Regressionsgerade Zeichnen

Kennzahlen der Regressionsanalyse R2

| Begriff | Beschreibung |

|---|---|

| R2 | Wie gut kann die abhängige Variable durch die unabhängige Variable vorhergesagt werden? |

| SSR | Sum of squares regression. Welcher Varianzanteil des Kriteriums kann mithilfe der Prädikatoren erklärt werden? |

| SST | Sum of squares total. Werte zwischen 0 und 1. Je höher der Wert, desto genauer die Vorhersage |

| yi | Abhängige Variable |

\tilde{y} |

Median der abhängigen Variable |

\hat{y} |

Vorhergesagte abhängige Varbiable |

Beispiel:

x = [1, 2, 3, 4, 5], y = [2, 3, 5, 4, 6]

\hat{y} = 0.9x+1.3

\hat{y} = [2.2, 3.1, 4, 4.9, 5.8]

- Median von y finden

y = [2, 3, 5, 4, 6] sortieren \rightarrow y = [2, 3, 4, 5, 6]

i_{\tilde{y}} = \frac{5+1}{2} = 3

\tilde{y} = y[i_{\tilde{y}}] = 4

- SST berechnen

SST = \sum_{i=1}^{n} (y_i-\tilde{y})^2

SST = (2-4)^2+(3-4)^2+(5-4)^2+(4-4)^2+(6-4)^2 = 10

- SSR berechnen

SSR = \sum_{i=1}^{n} \hat{y}_i-\tilde{y})^2

SSR = (2.2-4)^2+(3.1-4)^2+(4-4)^2+(4.9-4)^2+(5.8-4)^2 = 8.1

- R2 berechnen

R^2 = \frac{SSR}{SST}

R^2 = \frac{8.1}{10} = 0.81

- Interpretieren

0.81 bedeutet, dass viele der Datenpunkte in der Nähe der Regressionsgerade sind.

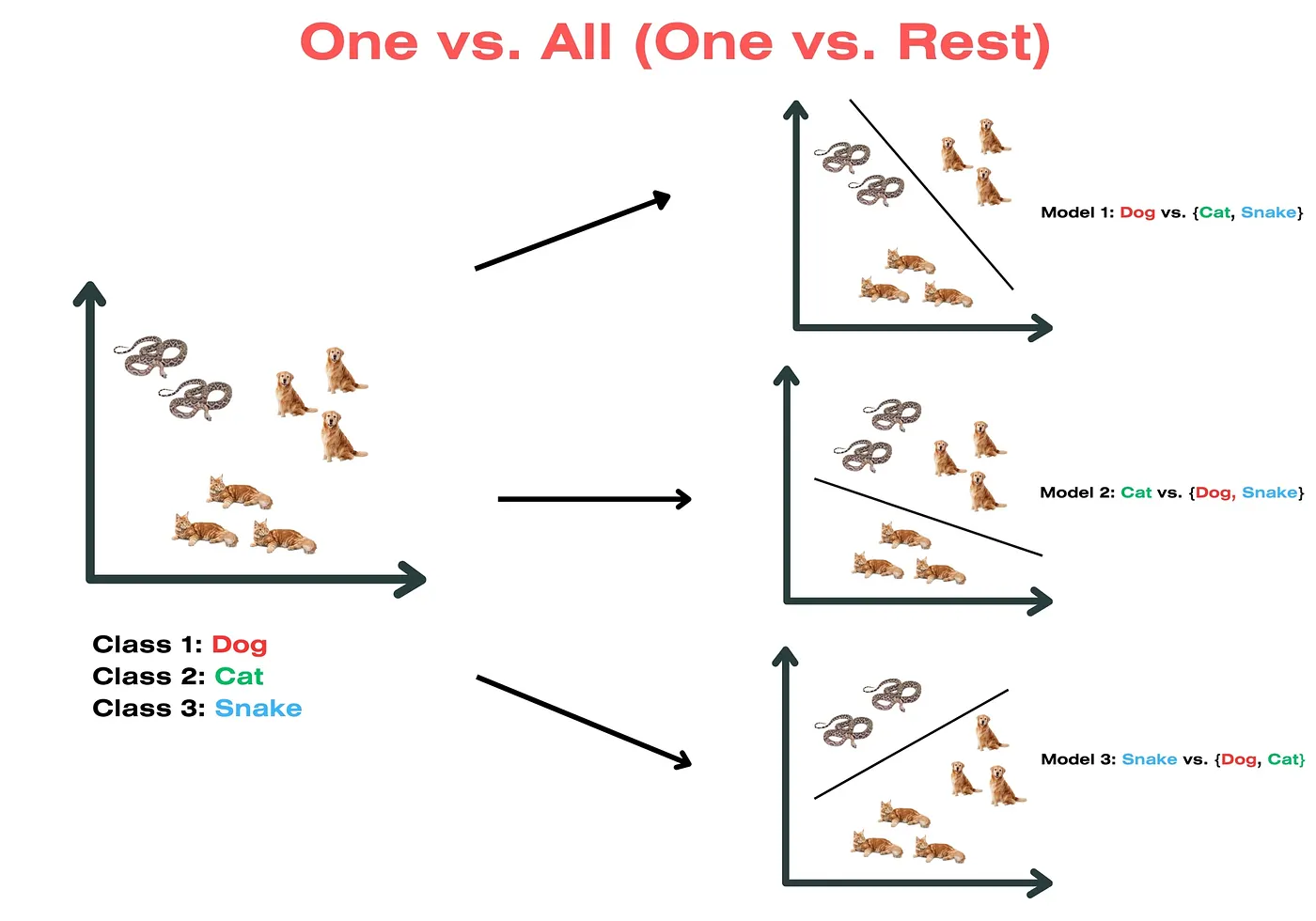

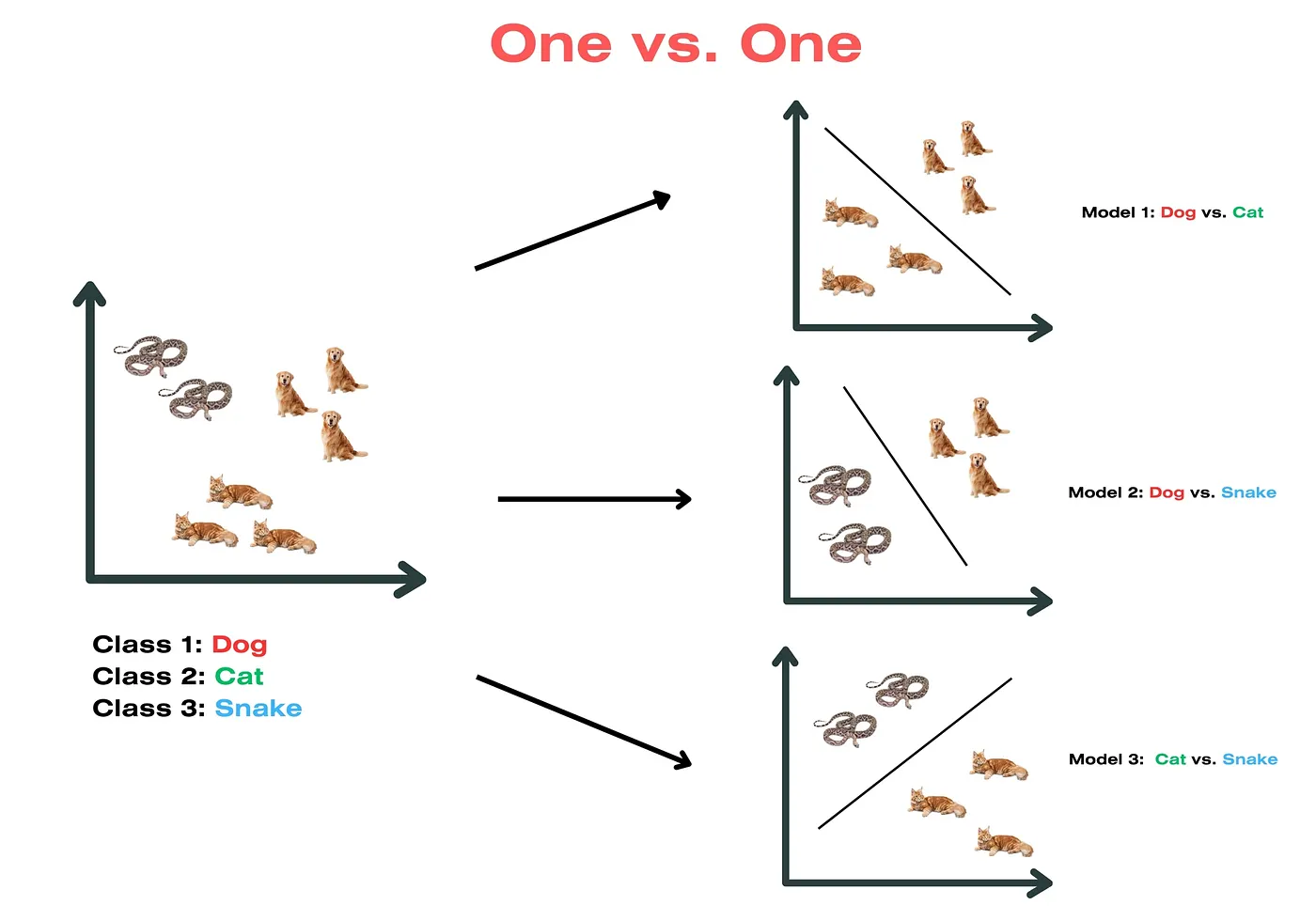

Klassifikation

Unsupervised Learning Clustering

| Begriff | Beschreibung |

|---|---|

| Clustering | Clustering kann als das wichtigste Problem des unüberwachten Lernens angesehen werden. Es befasst sich mit der Suche nach einer Struktur in einer Sammlung unbeschrifteter Daten. Eine grobe Definition von Clustering könnte der Prozess der Organisation von Objekten in Gruppen sein, deren Mitglieder sich in irgendeiner Weise ähneln. Ein Cluster ist daher eine Sammlung von Objekten, die sich untereinander ähneln und sich von den Objekten anderer Cluster unterscheiden. |

| Distanzmasse | Festzustellen, welche Datenpunkte innerhalb eines Clusters sich ähnlicher sind als andere. Distanzmasse werden tendenziell kleiner, je ähnlicher zwei Punkte sich sind. Beispiele:

|

| Ähnlichkeitsmasse | Bei Ähnlichkeitsmassen ist es andersherum: Bei größerer Ähnlichkeit zwischen zwei Punkten steigt ihr Wert. Beispiele:

|

| Euklidische Distanz | Abstand zwischen zwei Vektoren im mehrdimensionalen Raum. Bei der quadrierten euklidischen Distanz werden grosse Abstände zwishen den Vektoren stärker gewichtet als kleine Abstände. \large d(x,y)=\sqrt{\sum_{i=1}^{n} (x_i-y_i)^2} |

K-Means

K-Means ist einer der einfachsten Algorithmen für unüberwachtes Lernen, der das bekannte Clustering-Problem löst. Das Verfahren folgt einer einfachen und unkomplizierten Methode zur Klassifizierung eines gegebenen Datensatzes durch eine bestimmte Anzahl von Clustern, angenommen k Cluster, die a priori festgelegt sind. Die Grundidee besteht darin, k Zentren zu definieren, eines für jeden Cluster. Diese Zentren sollten auf intelligente Weise platziert werden, da unterschiedliche Positionen zu unterschiedlichen Ergebnissen führen. Daher ist es am besten, sie so weit wie möglich voneinander entfernt zu platzieren.

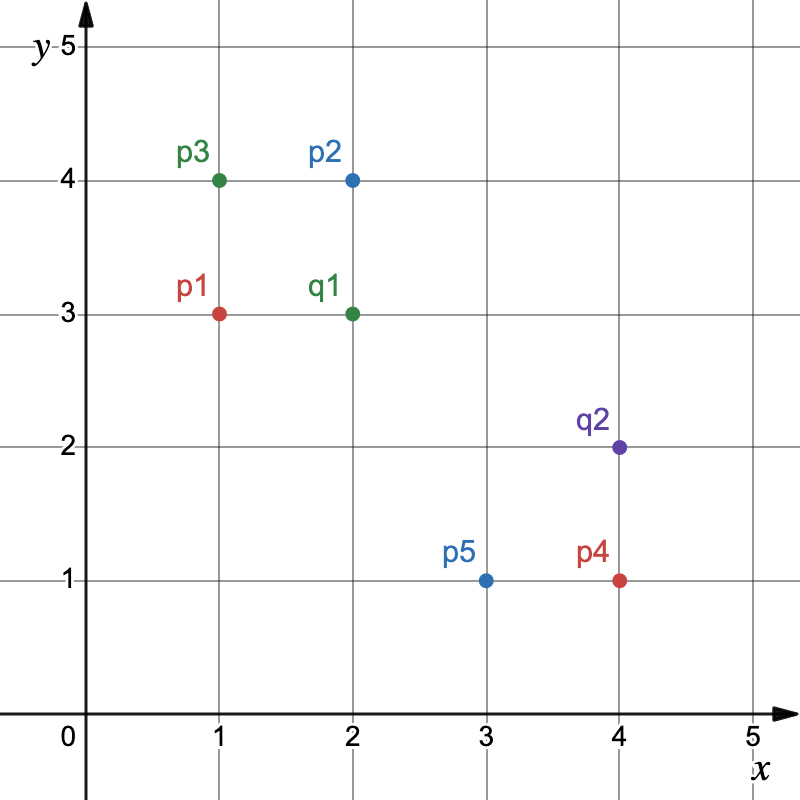

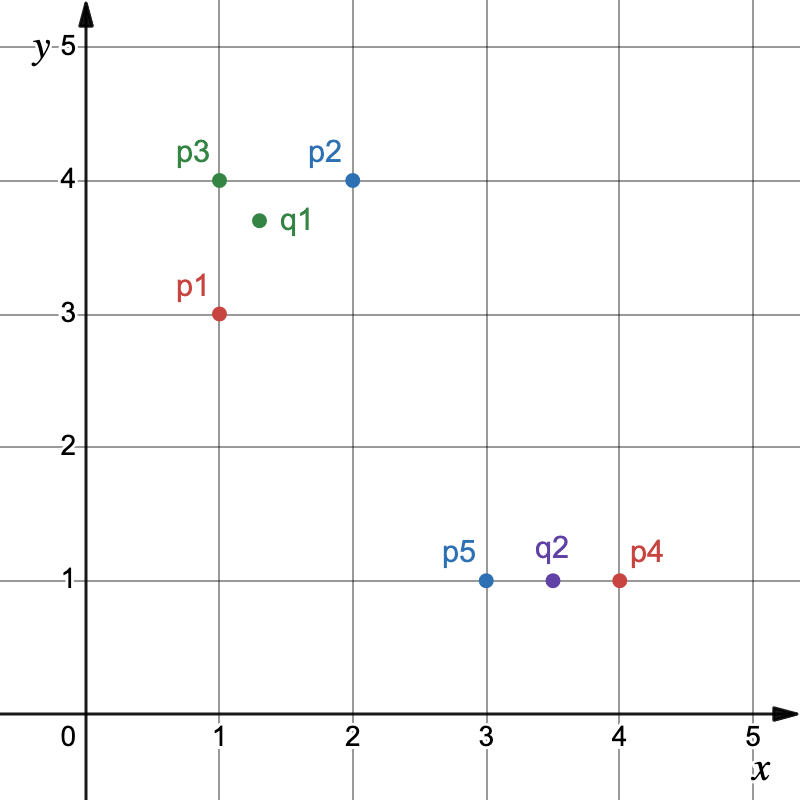

Beispiel fünf Elemente und zwei platzierte Cluster im mehrdimensionalen Raum:

- Quadrierte euklidische Distanz zwischen Punkte und Clusterzentren berechnen

d(x,y)=\sqrt{\sum_{i=1}^{n} (x_i-y_i)^2}^2 = \sum_{i=1}^{n} (x_i-y_i)^2

d(p1,q1)=(1-2)^2+(3-3)^2=1

d(p2,q1)=(2-2)^2+(4-3)^2=1

d(p3,q1)=(1-2)^2+(4-3)^2=2

d(p4,q1)=(4-2)^2+(1-3)^2=8

d(p5,q1)=(3-2)^2+(1-3)^2=5

d(p1,q2)=(1-4)^2+(3-2)^2=10

d(p2,q2)=(2-4)^2+(4-2)^2=8

d(p3,q2)=(1-4)^2+(4-2)^2=13

d(p4,q2)=(4-4)^2+(1-2)^2=1

d(p5,q2)=(3-4)^2+(1-2)^2=2

| p1 | p2 | p3 | p4 | p5 | |

|---|---|---|---|---|---|

| q1 | 1 | 1 | 2 | 8 | 5 |

| q2 | 10 | 8 | 13 | 1 | 2 |

- Punkte mittels Distanzfunktion zu Clusterzentren zuordnen

q1=\{p1(1,3), p2(2,4), p3(1,4)\}

q2=\{p4(4,1), p5(3,1)\}

- Neues Clusterzentrum berechnen

\frac{\sum_{i=1}^n \vec{x_i}}{n}

\frac{

\begin{pmatrix}

1 \\

3

\end{pmatrix}

+

\begin{pmatrix}

2 \\

4

\end{pmatrix}

+

\begin{pmatrix}

1 \\

4

\end{pmatrix}

}{3}=\begin{pmatrix}1.3 \\3.7\end{pmatrix}

\frac{

\begin{pmatrix}

4 \\

1

\end{pmatrix}

+

\begin{pmatrix}

3 \\

1

\end{pmatrix}

}{2}=\begin{pmatrix}3.5 \\1\end{pmatrix}

- Clusterzentren neu plotten